Data Pipeline dans Microsoft Fabric

Data Factory dans Fabric est un ensemble d’outils d’intégration de données basés sur le Cloud permettant aux utilisateurs de créer, planifier et gérer des pipelines de données au sein de l’écosystème Microsoft Fabric. Il étend les capacités du service Azure Data Factory (ADF) en s’intégrant profondément dans Microsoft Fabric, une plateforme d’analyse de données unifiée qui combine l’intégration de données, l’ingénierie des données, la science des données et la Business Intelligence.

Data Factory dans Microsoft Fabric

Désormais Data Factory dans Microsoft Fabric combine le meilleur des flux de données Power Query et des pipelines de données Azure Data Factory en un seul flux.

Data Factory garantit que vous disposiez toujours du moteur de transformation puissant et simple de Power Query pour la transformation des données. Il permet de toujours bénéficier de l’évolutivité des pipelines de données et de pouvoir créer un flux de contrôle de l’exécution de l’ETL à l’aide des pipelines de données. En d’autres termes, Data Factory est une offre logicielle en tant que service ETL de pointe pour Microsoft Fabric.

Qu'est-ce qu'un pipeline de données ?

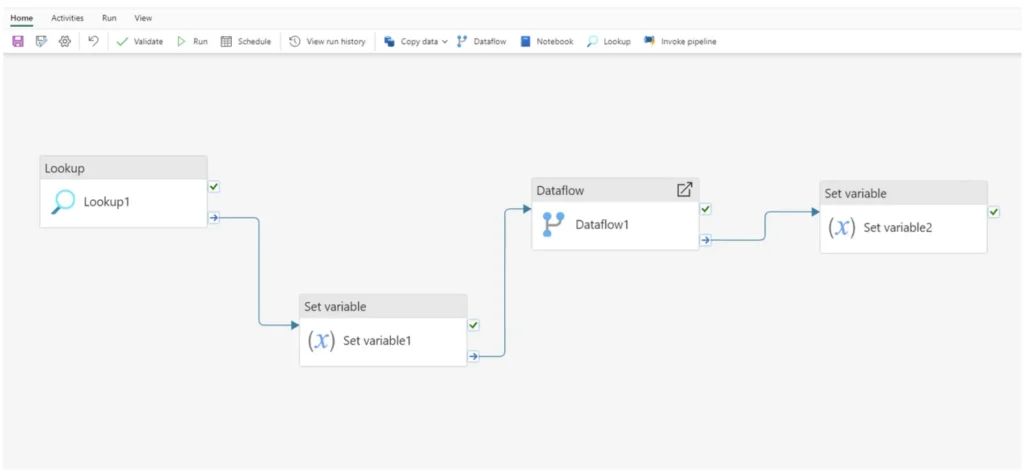

Illustration d’un pipeline de données dans Data Factory vue au travers de l’éditeur de Data Factory (Lookup / Set variable / Dataflow / Copy activity)

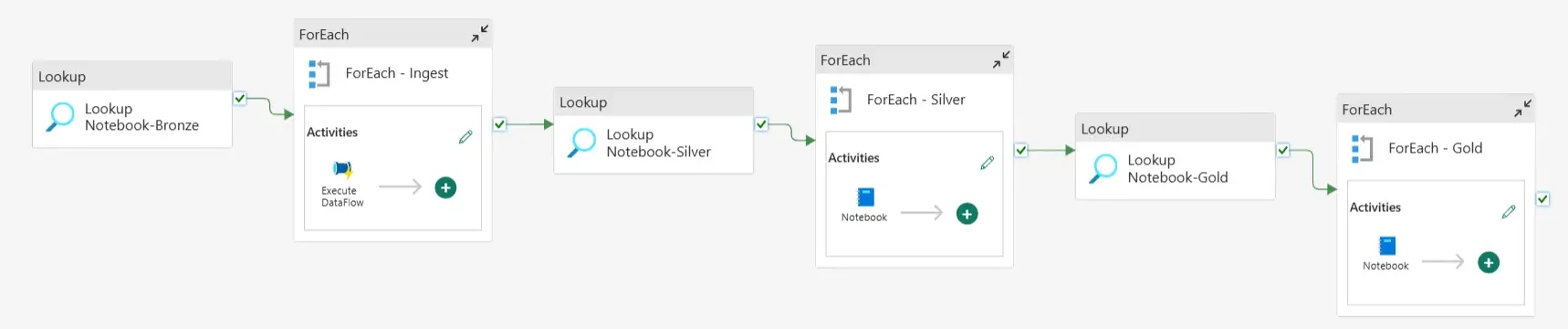

Un pipeline de données (Data Pipeline) est une série de processus et de flux de travail qui facilite le déplacement, l’orchestration et la transformation des données d’une ou plusieurs sources vers des destinations. Il peut être programmé pour automatiser le flux de données et garantir qu’elles sont accessibles et utilisables à des fins d’analyse, d’apprentissage automatique ou de reporting.

Les data pipeline sont utilisés pour créer un flux d’activités exécutables en vue d’effectuer des tâches spécifiques. Dans Data Factory pour Fabric, nous pouvons intégrer l’exécution d’un flux de données dans nos pipelines pour améliorer le processus ETL. Ceux-ci peuvent ensuite être programmés pour s’exécuter à certains moments ou déclenchés en fonction du résultat d’un autre flux.

Les étapes clés des Data Pipeline

Certaines des étapes clés des pipelines de données comprennent :

- Data Ingestion : Amener des données dans un pipeline.

- Data Transformation : La modification des données, leur nettoyage, leur préparation peuvent être effectuées avec Dataflows.

- Data Orchestration : Séquençage des pipelines de données. Par exemple, une source de données peut devoir terminer la mise à jour avant de commencer une deuxième étape d’ingestion de données.

- Data Output : Placer les données nouvelles ou mises à jour dans leur emplacement final.

- Data Monitoring : Notifications en cas d’échec des pipelines de données automatisés ou informations récapitulatives sur vos données telles que le nombre de lignes nulles, le nombre d’enregistrements copiés et des informations sur la qualité des données.

Comme vous pouvez le constater, le cas d’utilisation d’un pipeline de données est différent d’un flux de données. Alors que les flux de données sont principalement conçus pour transformer et préparer des données, les pipelines de données sont un outil professionnel permettant de déplacer des données entre des systèmes.

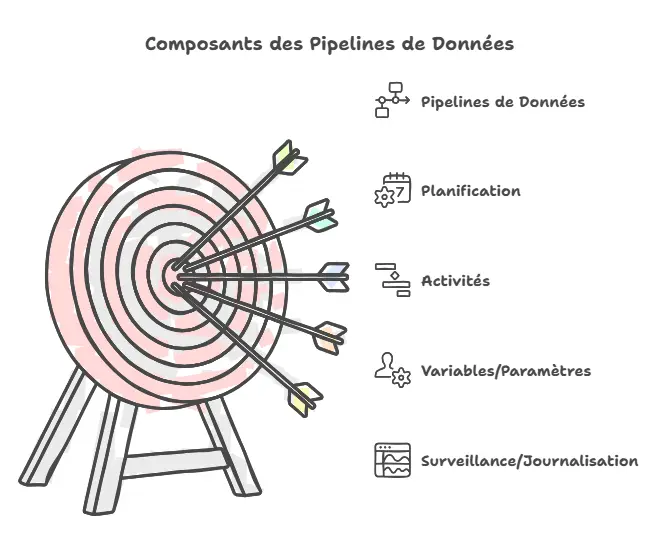

Les composants de Data Pipeline

Certaines des étapes clés des pipelines de données comprennent :

- Schedule

- Activités

- Variables / Paramètres

- Monitoring / Logging

- Connexions

Activités

La pierre angulaire des pipelines de données sont les activités qui nous permettent de faire n’importe quoi, depuis la copie de données, la suppression de données, le contrôle du flux de travail lui-même, l’orchestration d’autres tâches de calcul, jusqu’à l’envoi de messages de communication avec Outlook et les équipes.

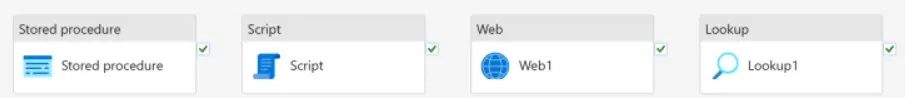

Les activités se composent de 4 types :

- Mouvement de données

- Transformer

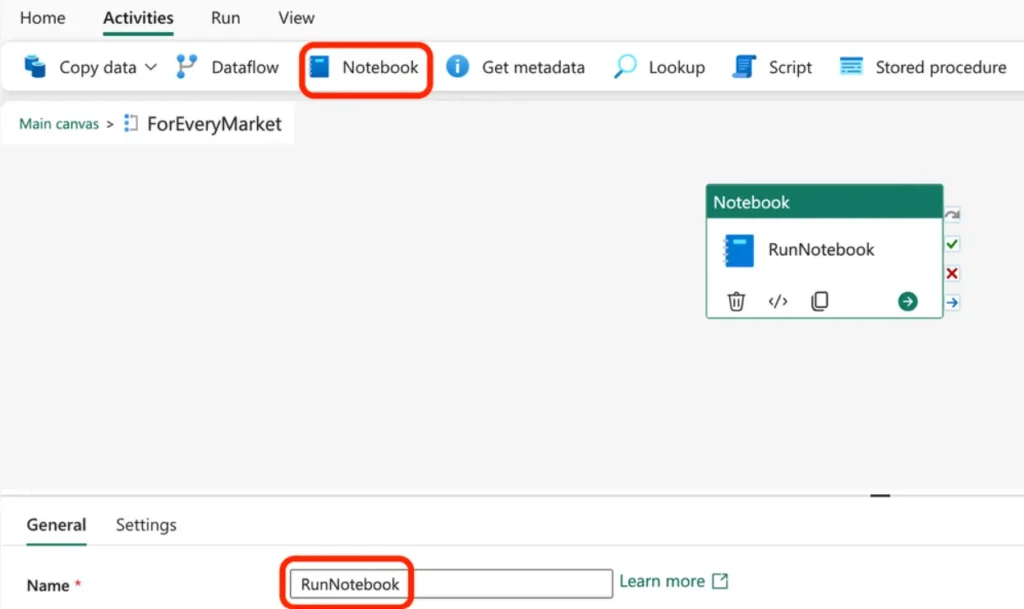

C’est le « T » de ETL . L’objectif est de nettoyer, ajouter des clones , enrichir les données…

Dans un contexte de transformation, il est possible d’ajouter une activité pour exécuter un Notebook en cliquant sur l’activité du Notebook.

- Orchestrer

L’objectif est de bien organiser le flux de travail en mettant en place un process (lineage de données). Cette tache peut être faite visuellement dans Data Factory.

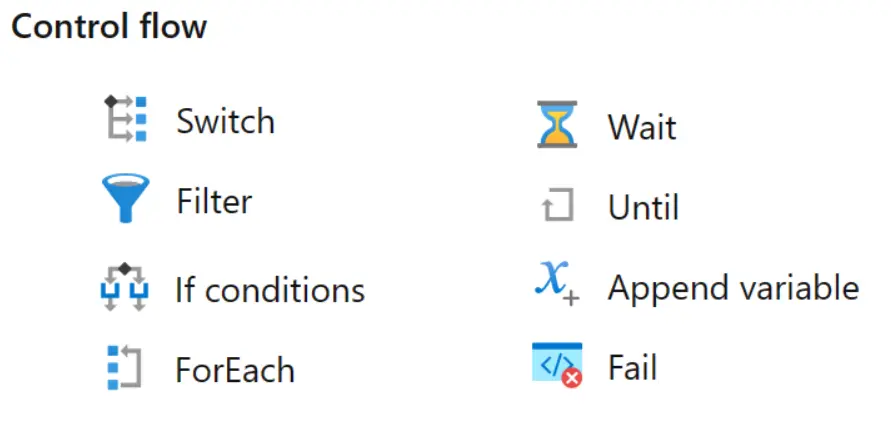

- Flux de contrôle

Il s’agit de contrôler l’approche de développement et donc l’efficacité de ce qui a été mis en place (qualité des données livrées).

Variables / Paramètres

- Les paramètres sont immuables et utilisés pour rendre les pipelines et les ensembles de données plus dynamiques et réutilisables. Leurs valeurs sont fixées au départ et restent constantes tout au long de l’exécution. Ils peuvent exister à plusieurs étendues, telles que les niveaux de pipeline, d’ensemble de données et de services liés, et être facultatif ou obligatoires. Bien qu’ils soient immuables, les paramètres peuvent toujours agir comme des pointeurs vers d’autres champs de saisie, ce qui les rend moins statiques en pratique.

- Les variables, en revanche, sont modifiables et limitées à un seul pipeline. Ils servent de stockage temporaire pour les valeurs qui peuvent changer pendant l’exécution du pipeline. Des activités telles que « Set variable » et « Increment variable » peuvent modifier leurs valeurs, les rendant utiles pour les processus et calculs itératifs.

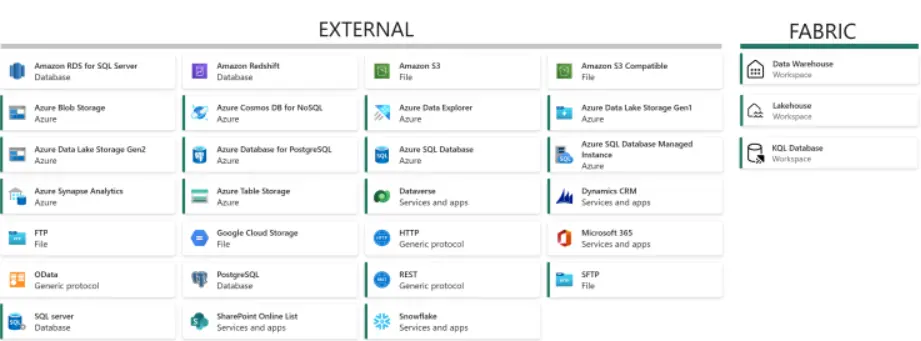

Connexions

-

Les connexions dans Microsoft Fabric nous permettent de connecter nos pipelines de données à des sources de données réelles. Trois types peuvent être trouvés sur la page de gestion des connexions : sur site, Réseau virtuel et Cloud. Au moment de la rédaction, seules les connexions Cloud fonctionnent avec les Data Pipelines mais les autres sont sur la feuille de route.

Schedule (Trigger)

Avoir un pipeline de données est excellent, mais sans l’exécuter, rien ne se passera ! Nous pouvons exécuter manuellement un pipeline et définir une planification, mais par rapport à Azure Data Factory, notre choix de déclencheurs pourrait être plus étendu.

Options de déclenchement disponibles :

- Exécution planifiée (à la minute, à l’heure, quotidiennement ou hebdomadairement)

- Exécuter le pipeline (pipelines de données déclenchant d’autres pipelines de données)

- Exécution manuelle (en cliquant sur « Exécuter » dans l’interface utilisateur à l’intérieur du pipeline)

Les planifications ne peuvent s’exécuter qu’à la minute, à l’heure, quotidiennement ou hebdomadairement.

Les pipelines peuvent toujours orchestrer d’autres pipelines, mais aucun des déclencheurs suivants n’est implémenté :

- Déclencheurs d’événements (Custom [Event Grid], Storage)

- Tumbling Window trigger

- API

Ainsi, malgré certaines limitations, nous disposons toujours d’une gamme dynamique de déclencheurs, et surtout de la capacité à pouvoir déclencher des pipelines de données à partir d’un autre pipeline tout en passant des paramètres entre eux. Ce qui permet de concevoir des modèles avancés et des pipelines hiérarchiques.

Monitoring and logging

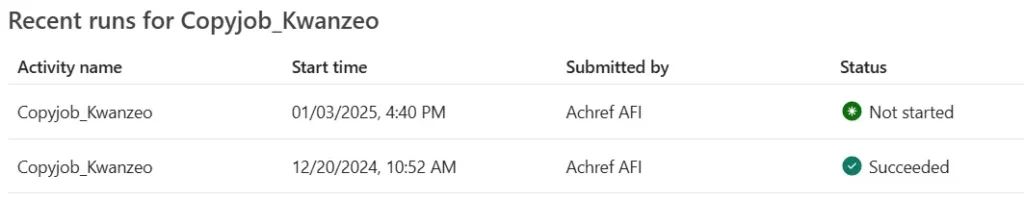

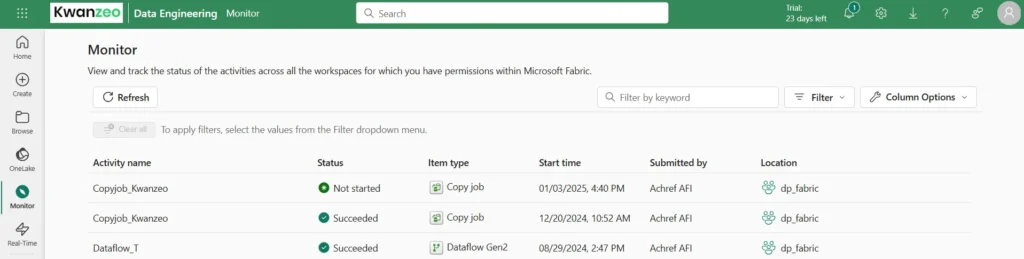

Nous pouvons surveiller toutes les exécutions de nos pipelines de manière native dans l’expérience utilisateur :

Alternativement, dans le Hub de surveillance, nous pouvons obtenir un aperçu complet de l’ensemble de Microsoft Fabric :

Pourquoi choisir Data Pipeline dans Fabric ?

Les pipelines de données Fabric sont conçus pour simplifier et automatiser le processus de déplacement, de transformation et de chargement des données vers la destination souhaitée. Ils offrent une approche rationalisée de la gestion des flux de travail de données, vous permettant de vous concentrer sur ce que vous faites le mieux : analyser les données et générer des informations.

Avantages :

Interface Low-Code / No-Code : Fabric Data Pipelines offre une interface drag-and-drop pour concevoir des flux de données, la rendant accessible aussi bien aux développeurs citoyens qu’aux ingénieurs de données.

Conçu pour les charges de travail modernes (Real-Time & Batch) : Fabric Data Pipelines prend en charge à la fois le traitement par lots pour de gros volumes de données et le streaming en temps réel pour les applications IoT et événementielles.

Intégration avec Microsoft Power BI : Les Fabric Data Pipelines sont profondément intégrés à Power BI, ce qui facilite le déplacement de données provenant de diverses sources vers des ensembles de données Power BI pour obtenir des informations en temps réel.

Scalabilité et Performance : Fabric Data Pipelines repose sur l’infrastructure évolutive d’Azure, qui peut gérer à la fois le traitement des données par lots et en temps réel pour les charges de travail à grande échelle.

Certains des cas d’utilisation les plus typiques des pipelines de données impliquent :

- Mouvement de données automatisé pour l’ingestion ou l’intégration de données – particulièrement puissant grâce aux fonctionnalités de sécurité des données et aux configurations de tolérance aux pannes.

- Orchestration de pipelines de données complets de bout en bout – en utilisant la gestion des dépendances, la surveillance, la journalisation, la capture de métadonnées et la gestion de la concurrence.*

- Transformations légères et mappage de schéma – en utilisant les capacités de mappage intégrées et les requêtes dynamiques. Il n’est pas conseillé d’intégrer trop de logique métier dans les pipelines de données, car cela peut nuire à la fois aux performances et à l’explicabilité de vos flux de travail. Les pipelines de données en tant que service ne sont pas un moteur de transformation à grande échelle comme Spark, les flux de données ou SQL dans l’entrepôt.