Mai 2023 - Décryptage : Microsoft Fabric par Ismaïl, Directeur du Pôle Data Intelligence

Fabric, votre nouveau tissu pour faire... de la Data !

« L’événement Microsoft Build 2023 était à peine lancé à Seattle que la nouvelle a rapidement fait le tour des réseaux sociaux professionnels : un nouveau logo vert représentant un « F » voit le jour et vient enrichir la famille (déjà bien fournie !) de services Microsoft… Fabric est là et promet, dès le départ, de révolutionner votre existant Data, rien que ça !!!

Il n’en fallait pas plus pour que les terminologies classiques de « Exciting » et « Game Changer » refassent leur apparition alors même que le service est encore en « Preview » et que, mise à part les Microsoftees et probablement quelques privilégiés, le reste ne l’a pas encore expérimenté…

Fabric is the new Synapse ? Power BI passe à la vitesse supérieure et rafle tout en devenant une solution de bout en bout ? Faut-il revoir toutes les architectures ? Quel prix, quels usages, quelles populations cibles ? Quelle est la part de l’IA dans tout cela ? Essayons de démêler les fils de ce « tissu » en restant « calme » et pragmatique.

Pour commencer, nous apprenons que la nouvelle offre Microsoft Fabric prône une expérience « All-in-One » en mode « SaaS » pour simplifier l’ingestion, la transformation et la présentation de la donnée. Il s’agit donc de regrouper tous les workloads (Data Factory, Data Engineering, Data Science, Data Warehousing, Real-Time Analytics et Power BI) dans une seule et même interface utilisateur (une interface à la Power BI ?!). La donnée y sera, de ce fait, gouvernée, centralisée (avènement du concept unifié de « One Lake » qui permet de passer outre la nécessité d’extraire, déplacer ou répliquer la donnée, réduisant ainsi le risque de silotage) et sécurisée.

Microsoft Fabric promet donc d’être une Data Platform qui mixera le meilleur de Power BI, Azure Synapse et Azure Data Factory pour le plus grand plaisir des Data Engineers, Data Scientists, Data Analysts et même les Business Users. Nous devrions ainsi voir :

- Data Factory : un Power Query à la sauce Azure Data Factory –> Enrichissement de l’offre Power BI dans sa stack de Data Preparation si je comprends bien ?

- Synapse Data Engineering : une plateforme Spark plus robuste basée sur un concept de lakehouse –> Databricks, es-tu là ?

- Synapse Data Warehouse : un entrepôt fully managed en mode SaaS et avec du serverless notamment –> Snowflake, c’est toi ?

- Synapse Data Science : du SynapseML, le support du langage R, peut-on lire par-ci, par-là –> Je laisse mes Data Scientists Kwanzeo me dire ce qu’il en est.

- Synapse Real-Time Analytics : là aussi un service / concept déjà existant, à voir quels sont les gains réels sur cette partie…

- Data Activator : du no-code pour détecter et trigger des actions à partir de patterns (seuils, trends, …) sur vos données –> nouveau concept à explorer mais ça me semble être une version améliorée / revisitée de Metrics dans Power BI ?

- OneLake : le concept de OneDrive pour vos données (il aura même une version Windows Explorer !), une sorte de Data Lake multi-clouds en mode SaaS qui promet d’être riche, complet et sécurisé (tout le concept de Fabric repose dessus…). Il est compatible avec les architectures de type Data Mesh et semble reposer sur le principe des Workspaces Power BI. Les données y sont stockées au format delta parquet.

La partie IA n’est forcément pas en reste dans Microsoft Fabric puisqu’elle intégrera Copilot (basé sur Azure OpenAI) afin de permettre le requêtage en langage naturel lors de la génération des codes et des requêtes ou encore la création en mode low / no code des plugins IA.

Microsoft Fabric assure également une compatibilité totale avec la suite Microsoft 365, Teams et Power BI.

Quid, justement, de Power BI dans tout cela ?

Power BI n’est pas en reste des annonces de Microsoft Build 2023 puisqu’il s’enrichit de nouveautés comme :

- La Gen2 de Power BI Dataflow

- Power BI DirectLake : parce que les modes Import et Direct Query sont has been et qu’il faut directement puiser ses données sur le OneLake à présent. La performance serait au RDV. Lien vers un essai plus complet

- Power BI Desktop Developer Mode pour intégrer vos datasets et vos rapports dans Git –> enfin l’avènement du versioning natif dans Power BI ! Mais à quel prix et pour quel type de licence, je n’ai pas encore bien exploré cette partie (pour tout Microsoft Fabric d’ailleurs).

- La version « All-in-One » du service PowerBI semble d’ailleurs annoncer la fin proche de PowerBI Desktop. A confirmer dans les jours à venir mais cela serait dans la continuité logique de toutes ces évolutions de Power BI Service… Wait and see donc…

En résumé, un nouveau buzz de la firme du Redmond qui entend bien mettre KO ses concurrents. Il est encore tôt, à mon sens, pour juger tout cela (l’offre est toujours en PREVIEW, ne l’oublions pas) et il y aura, in fine, et quoi qu’il arrive, toujours des pour et des contres, des partisans et des contestataires mais bon le marché de la Data est dynamique et la concurrence est rude. Tant mieux pour nous et pour notre patrimoine Data qui ne pourra que se bonifier !

Fabric, et si on parlait licensing ?

Dans cette nouvelle partie, nous allons tenter de répondre à la question si chère à feu Jean-Pierre Pernaut : « Combien ça coûte ?«

Eh oui, quid de la fameuse calculatrice Azure qui nous permettait d’avoir une première idée sur le budget à prévoir ? Le Pay-As-You-Go (PAYG) est encore d’actualité ou faut-il passer par la case engagement (1 an, 3 ans, …) pour avoir droit à une jolie ristourne ? Si Fabric reprend l’identité de Power BI Service, reprend il également le principe de la capacité dédiée ? Que deviennent les licences Power BI Pro et PPU (Premium Per User) ?

Bref, le mystère demeurait entier jusqu’au 01/06/2023, date à laquelle Microsoft a fini par lever le voile via une communication officielle.

On y apprend, en résumé, que le licensing de Fabric reposera sur la notion de capacité (tout comme Power BI donc). Une seule capacité de compute suffirait (attention à bien la sizer quand même !) à gérer simultanément tous les workloads (charges de travail) des 6 piliers de l’offre :

Cette capacité pourrait même être partagée entre plusieurs utilisateurs et différents projets sans aucune limite en nombre de workspaces ou de profils de type « Creator » !

Dans la même logique, un seul tenant pourrait avoir plusieurs capacités, chacune gérée par une entité business différente par exemple (Data Mesh compatible ?)

Pour obtenir ou souscrire à une capacité Fabric, il faudrait soit :

Vous êtes alors dans le scénario Pay-As-You-Go (PAYG) avec une facturation à la seconde (première minute indivisible) et pas d’engagement. Ce scénario vous permet surtout de faire du scaling up et down de votre capacité ou encore de la mettre en pause et de la relancer en cas de besoin (le FinOps et votre portefeuille vous en remercieront)

Vous l’aurez compris, la facturation dans Fabric dépendra encore et toujours du compute (taille de la capacité) et du storage dans OneLake (qui reprendra le faible coût de stockage de Azure Data Lake Storage).

Vous constaterez également que la liberté de scaling et de pause dans une SKU Azure (qui est en PAYG pour rappel) la rend logiquement plus chère (mais pas forcément moins intéressante…) qu’une SKU Microsoft 365 !

Mais bon vu que Microsoft vise la Fabric pour tou(te)s avec un prix d’entrée de 9$ par jour (pour une F2 en PAYG), il n’y a plus qu’à…

En ce qui concerne les licences Pro de Power BI, pas de changement de cap chez Microsoft : il en faudra toujours une par utilisateur qu’il soit créateur ou consommateur de rapports.

A moins de souscrire au minimum à une capacité Fabric SKU F64 (équivalente à une Power BI Premium P1 comme vu plus haut) qui exempterait, dans ce cas, les consommateurs de rapports d’une licence Pro et pourrait même leur permettre d’utiliser des pipelines et des notebooks, de créer des Data Warehouses ou, encore, de gérer leur capacités.

Reste, bien évidemment, à trouver le bon scénario pour ces nouveaux usages de personas.

On ne le répétera jamais assez mais l’essai gratuit de 60 jours constitue une excellente opportunité pour tester Fabric sous toutes ces coutures et vous donnera même une première idée de la taille de la capacité à prévoir pour vos futurs (et réels) workloads… en attendant la probable sortie prochaine d’une calculatrice Fabric !

D’ici là, à vos tests et on se tient au courant pour la suite 😉 »

Kwanzeo reste votre partenaire pour vous accompagner dans vos projets Data par l’audit, l’accompagnement, la formation ou la délégation. N’hésitez pas à nous contacter pour bénéficier de démos, pour nous demander notre programme de formations et pour vous inscrire à nos événements (webinaires Data, « Café technologique », …) et vous pouvez suivre notre actualités et nos publications sur notre page LinkedIn KWANZEO 🙂

Fabric à l'épreuve de la pratique

« Time flies, comme on dit !

Voilà déjà plus d’un mois que l’offre Fabric, la Data Platform en mode SaaS de Microsoft, est sortie en Public Preview et presque autant de jours que le trial a été activé de mon côté.

J’ai donc pu faire des tests sur les briques de l’offre qui me concernent au quotidien et je profite de ce troisième opus pour vous livrer mes impressions sur les points forts et les points d’amélioration.

Fabric, la « prise en main » !

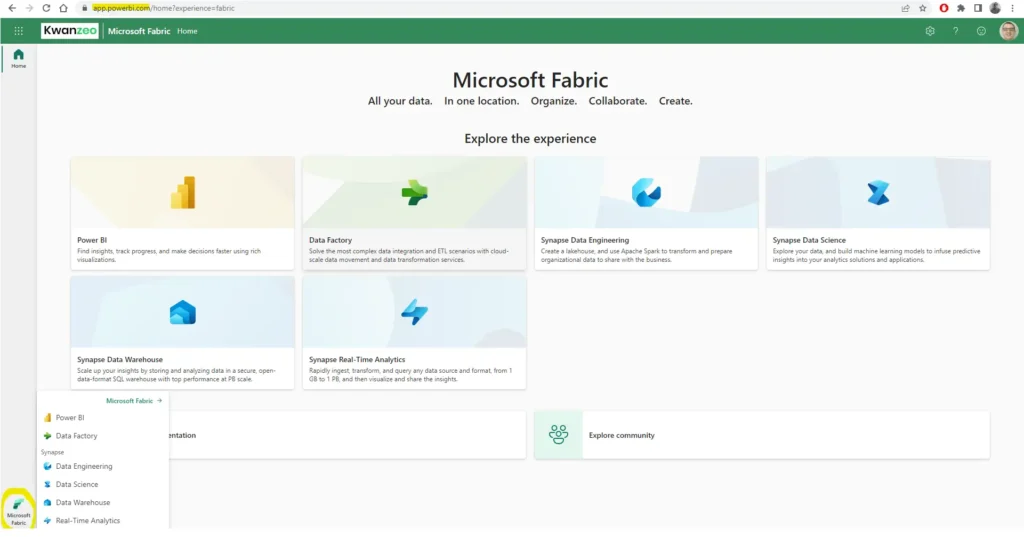

Si vous avez eu l’occasion de manipuler Power BI Service, pas d’inquiétude, vous êtes en terrain conquis ! La même URL permettra désormais d’accéder aux différentes expériences :

Avantage indéniable pour les amateurs du « All-in-One » qui apprécient de ne pas devoir basculer d’une interface à une autre, surtout avec cette récente nouveauté d’onglets flottants sur le menu de gauche,

et tout se fait / se regroupe sous l’étendard du classique Workspace de Power BI !

Nous ne sommes pourtant pas à l’abri de perturber les utilisateurs de Power BI qui peuvent se retrouver noyés dans de nouvelles fonctionnalités pas nécessairement utiles pour eux et vont finir par se demander si leur utilisation de Power BI risque d’être impactée…

Point d’inquiétude, la firme du Redmond n’ira pas « balayer d’un revers de main » le leader du marché de l’Analytics (depuis 2019 dixit Gartner).

L’usage et surtout le principe de licensing de Power BI reste le même.

Attention, donc à bien dissiper les doutes de vos Data Analysts et vos personas Power BI et à bien les accompagner vers cette phase Fabric qui se généralise.

Fabric, remplaçant de Synapse ?

Azure Synapse Analytics est déjà une solution « All-in-One » prônant le PaaS et le contrôle aussi fin que possible.

Pourquoi donc tout rebrander sous Fabric en SaaS ? Dois-je encore capitaliser sur Synapse ?

Questions légitimes posées à maintes reprises : « Fabric est l’umbrella qui va regrouper Synapse et PowerBI tout en les rendant plus simples et plus accessibles« , « Pas d’inquiétude Synapse est encore là » peut-on lire et comprendre sur les références Web.

Jusqu’à quand ? Surtout quand on voit que Fabric reprend les fonctionnalités de Synapse, les intègre dans le « thème » Power BI en leur apportant les principes affutés et réussis de ses « homologues » Databricks et Snowflake (Lakehouse, SaaS, Serverless, Spark robustifié, …)

Je n’ai pas encore de boule de cristal mais tout comme je voyais Power BI Desktop disparaître prochainement, je pense que Synapse tel qu’on le connaît actuellement finira par disparaître au profit de son pendant dans Fabric… Wait and see 🙂

Fabric, Team Lakehouse ou Warehouse ?

Chacun sa préférence ! Qu’on vienne d’un passif tabulaire avec des contraintes bien rôdées et des données bien structurées ou que l’on soit ouvert (et parfois contraint) aux données non structurées ou semi structurées, on saura choisir sa voie sous Fabric…

En effet, si vous êtes plutôt Team Lakehouse, vous aurez :

- Une capacité de stockage « illimitée » (pas de communication à ce sujet mais la facturation suivra 🙂 )

- La simplicité de l’utilisation

- L’opportunité de coder en Spark (Scala, PySpark, Spark SQL, R) ou T-SQL même si vous arriverez à faire beaucoup de choses graphiquement

- La diversification des données (Fichiers, Tables),

- La possibilité d’uploader et gérer des dossiers (arborescences) et des fichiers,

- La possibilité de prévisualiser les données de votre fichier,

- La facilité de passage d’un format fichier vers un format tabulaire basé sur le Delta/ Parquet via un clic droit,

- L’accès à un SQL Endpoint afin de faire des requêtes « simples » (DQL uniquement mais pas (encore ?) de DML ou DDL) et un seul schéma (dbo) possible (pour le moment…), du reporting ou encore faire de la modélisation,

- Le stockage de vos données au niveau du One Lake,

- La possibilité de faire un Direct Lake (le mix amélioré des modes Import et Direct Query) sur vos données mais depuis Power BI (Fabric) service uniquement (pour le moment…),

- La possibilité de rajouter un shortcut (un lien en Read-Only vers une source sans avoir à déplacer ses données) vers une source interne (dans le One Lake) ou externe (depuis Azure Data Lake Storage Gen 2 ou Amazon S3 uniquement (pour le moment…)).

> Si vous êtes Team Warehouse, vous aurez :

- Le cadre usuel d’un entrepôt de données avec la possibilité de gérer des schémas, des procédures stockées, des vues, des tables, etc.

- La possibilité de faire du DQL, DML et DDL,

- La possibilité de faire de la modélisation,

- La possibilité de faire un rapport sur le dataset par défaut ou de créer un nouveau dataset,

- La possibilité de faire un « Incremental Refresh » (option disponible mais grisée pour le moment)

- Le stockage là aussi illimité de vos données au niveau du One Lake –> Ce qui l’oppose directement à Power BI Datamart dont on n’entend plus trop parler mais dont les fonctionnalités sont bien reprises dans Fabric…,

- Un SQL Endpoint afin de pouvoir se connecter au Warehouse depuis un outil externe (SQL Server Management Studio, Azure Data Studio, Power BI…).

Vous remarquerez, au passage, les points communs entre un Lakehouse et un Warehouse notamment sur le point de terminaison SQL, le stockage des données sur One Lake dans un format ouvert (delta, parquet) ou encore les fonctionnalités de reporting.

Pourquoi avoir à choisir quand on peut (si le scénario d’usage le permet ou le dicte) les combiner tous les deux dans une architecture moderne et robuste ?

Fabric et l'intégration des données

Data Factory, Data pipeline, Dataflow Gen2… autant d’appellations et de fonctionnalités accessibles à partir de plus d’un endroit dans Fabric. Comment s’y retrouver et à quoi cela correspond ?

- Data Factory : il s’agit de l’un des piliers de l’offre Fabric qui regroupe : Dataflow Gen2 (Preview) et Data pipeline (Preview)

Cela devrait vous rappeler SSIS ou Azure Data Factory avec ses briques de flux de contrôle (Data pipeline) et de flux de données (Data flow Gen2).

- Data pipeline : Les activités actuellement permises dans une pipeline sont :

« Copy data, Dataflow, Notebook, Get metadata, Lookup, Script, Stored procedure, Set variable, If condition, ForEach, Web, Invoke pipeline, Office 365 Outlook, + More activities. »

J’ai personnellement apprécié l’expérience de « Copy data » via l’assistant (capable de générer automatiquement un foreach et les paramètres associés) et j’ai retrouvé certains de mes reflexes sous Azure Data Factory (en attendant la déclinaison de l’option récente de désactivation d’une tâche dans une pipeline 🙂 ).

J’aurais, néanmoins, aimé que le menu bas de Azure Data Factory soit rebrandé en une expérience client plus agréable (un mix amélioré de SSIS et de Power Query).

L’activité « Dataflow » vous permet d’appeler un flux de données (Dataflow Gen1 ou Gen2) depuis une pipeline. De quoi compléter, si besoin, votre T (de Transformation) dans votre flux ELT / ETL.

- Dataflow Gen2 : certainement mon coup de cœur de l’offre enfin… presque !

Je me suis toujours demandé pourquoi le Dataflow Gen1 se limitait à une cible Data Lake interne (ou externe sous Premium)… Et voilà que ma « wishlist » est entendue ! En effet, la Gen2 de Dataflow propose désormais un « vrai » ETL avec :

- Toujours la richesse des connecteurs multi-sources,

- La puissance et la simplicité de Power Query,

- Désormais la possibilité d’injecter ses données traitées dans une destination… Cloud et Microsoft uniquement.

Fabric, soucis rencontrés et points d'attention

Lors de mon essai du Dataflow Gen2, je me suis connecté à une source SQL Server On-Premise et malgré la fluidité du process jusqu’à la destination, je ne suis pas arrivé à actualiser mon Dataflow Gen2 pour une raison inconnue et une erreur « farfelue » : « Errors : There was a problem refreshing the dataflow. Please try again later. Search online. »

Pas de solution miracle trouvée sur internet et ailleurs. Je me suis donc rabattue sur le Gen1 de Dataflow et cela a bien marché du premier coup… Je vais donc me dire (sans aucune certitude) que la priorité n’a sûrement pas été donnée aux sources On-Premises lors de cette preview…

Autre point d’attention, si comme moi, vous avez une cible Snowflake, n’oubliez pas de prévoir un stage intermédiaire de type Azure Blob Storage (ou Amazon S3) afin de vous éviter cette erreur : « Direct copying data to Snowflake is only supported when source dataset is DelimitedText, Parquet, JSON with Azure Blob Storage or Amazon S3 linked service, please enable staging. »

Sinon le connecteur Snowflake dans Fabric tient la route et assure une commande « Copy Into » avec des performances globalement intéressantes.

> Fabric, des extensions

Parce que Microsoft Fabric ne se limite pas à l’interface web « inspirée » de Power BI service mais vient également avec au moins deux extensions intéressantes à considérer :

On dit que « le One Lake est le One Drive pour la Data ». Avec cet explorateur, cette affirmation prend tout son sens ! Depuis l’explorateur Windows, vous pourrez accéder, à la manière d’un One Drive classique, au contenu synchronisé de vos Lakehouses et Warehouses (fichiers, parquets, delta) et même y déplacer manuellement ou automatiquement (avec le script adéquat) vos fichiers sources (CSV, Json, …) afin de les retraiter au format Delta / Parquet dans la foulée. En somme, un outil simple à installer et à utiliser que je ne peux que vous recommander !

Une App Power BI facile à ajouter (depuis l’App Source) et à installer qui permet de remonter, dans un rapport Power BI, des indicateurs autour de l’usage de Fabric.

Quel item est le plus gourmand en termes de mémoire utilisée, temps de process, usage CPU ? Quel item est le plus populaire auprès des utilisateurs ?

L’App nous donne des informations certes intéressantes sur les différents metrics mais je reste sur ma faim quant à la partie costing ou la scalabilité qu’il y a eu sur mes traitements !

Eh oui, n’oublions pas que nous sommes en phase de test et que le trial (calibré sur un F64 (équivalent à une capacité Premium P1)) a une date limite ! Le choix du futur SKU Fx est important et l’information manque à ce niveau, je trouve… Je pensais que l’app suffirait mais visiblement pas !

Voilà donc pour ce tour d'horizon de Fabric !

En résumé, et de ce que j’ai pu en tester, Fabric est une offre intéressante d’un point de vue fonctionnalités. Le marché Data Platform ne fait que converger entre les différents acteurs et c’est plutôt rassurant.

J’ai pu, pour ma part, atteindre mes objectifs de test sous Fabric sans trop de pépins. Certains bugs ou fonctionnalités mineures inexistantes nous rappellent que nous sommes encore en Preview et que l’offre va certainement se bonifier avec les différents feedbacks de la communauté.

Comme évoqué plus haut, je reste sur un goût d’inachevé sur la partie FinOps (vous avez consommé tel crédit, il y a eu tel scale up / down, ….) afin de pouvoir ajuster mes traitements et surtout me projeter sur une facturation réaliste (à défaut d’une réelle, utopique) dans un contexte projet !

D’ici à la sortie définitive de Microsoft Fabric, les tests continuent de mon côté et vos feedbacks sont, bien évidemment, toujours les bienvenus ! À bientôt ! »